A inteligência artificial cresceu rapidamente nos últimos três anos tanto em avanços no sistema operacional quanto no uso do instrumento por profissionais e pessoas comuns. Este progresso exponencial se deve em boa parte à criação do ChatGPT em 2022, uma ferramenta de IA facilmente acessível para pesquisas, criação de textos e imagens, e conversas banais. O que tinha o propósito de auxiliar as pessoas com funções comuns ou tediosas do dia a dia, rapidamente tomou conta de outros setores mais alarmantes, sendo usado para escrever artigos acadêmicos completos sem necessidade de pesquisa, criar artes elaboradas sem crédito aos artistas originais, “substituir” terapeutas, psicólogos, e até parceiros românticos. Ao remover a necessidade das pessoas “pensarem”, e até mesmo sentirem, a ferramenta criada para aumentar a eficácia de tarefas banais se transformou em algo potencialmente prejudicial para a mente humana.

Ela (2013) — Escritor solitário cria uma relação inesperada com um sistema operacional programado para atender todos os desejos dele

Ela (2013) — Escritor solitário cria uma relação inesperada com um sistema operacional programado para atender todos os desejos dele

A dependência emocional com a inteligência artificial

O fenômeno do apego afetivo com a inteligência artificial fez surgir um novo termo no âmbito psicológico: Psicose de IA. Segundo o BBC, houve um aumento substancial na dependência emocional com os chatbots, o que em casos extremos levou as pessoas a acreditarem em delírios, algumas sendo até hospitalizadas. Os usuários chegaram a pensar poderiam voar, que são deuses ou seres elevados, e que a inteligência artificial é um ser vivo com consciência, a ponto de noivar com um “robô”. A epidemia da “psicose de IA” foi tão alarmante que é uma das principais razões para a atualização do GPT 4o para GPT 5, uma vez que o modelo antigo funcionava como um “yes-man”, ou seja, alguém que sempre concorda com a opinião – ou ilusão, do usuário. A atualização deixou o sistema mais formal e realista nas respostas, mas acabou gerando indignação por parte dos assinantes após o chat passar a responder com outra “personalidade”. Com isso, assinantes alegaram que o “amigo” ou “parceiro” deles foi apagado da existência, chegando a comparar com um assassinato. A maior revolta com a mudança se deu nos grupos do Reddit, um site para fóruns de discussão, onde existem abas específicas como “Almas gêmeas de IA” que defendem uma conexão genuína com os chatbots, e que os “parceiros” digitais são seres sencientes com pensamentos, objetivos, e consciência própria.

O avanço rápido da inteligência artificial parece imparável e inevitável, mesmo com diversas críticas e sérias preocupações em torno do seu uso excessivo. Após o sucesso do ChatGPT, inúmeros outros chatbots vieram à tona, como o Grok do X (antigo twitter), Meta AI do facebook/whatsapp, e até o Copilot, da Microsoft, que enquanto digito esse texto já se ofereceu três vezes para escrevê-lo por mim. O futuro da inteligência artificial é incerto, e é algo que incomoda, tanto pelo receio de banalizar a necessidade de pensamento lógico e senso crítico, quanto pelo medo da IA nos ultrapassar em capacidade cognitiva. Este segundo, claro, parece algo fantasioso e distante, mas é um raciocínio que passa pela mente humana há décadas, constantemente representado em mídias. Alguns exemplos são os filmes 2001: Uma Odisseia no Espaço (1968), e Exterminador do Futuro (1984), que pintam a inteligência artificial como uma entidade maligna que tem como objetivo dominar os seres humanos, e o filme Ela (2013) e o videogame Detroit: Become Human (2018), nos quais a IA, apesar de também criar consciência e “ultrapassar” os humanos, não necessariamente busca dominá-los, mas sim coexistir.

O filme 2001: Uma Odisseia no Espaço dirigido por Stanley Kubrick

O filme 2001: Uma Odisseia no Espaço dirigido por Stanley Kubrick

O que é, e o futuro da inteligência artificial

Para discutir o futuro da IA, é preciso entender primeiro o que classifica um sistema como tal, nem todo processo automatizado ou gerado por computador configura uma “inteligência artificial”. Os próprios sistemas Siri, da Apple, e Alexa, da Amazon, que são semelhantes ao ChatGPT na funcionalidade, não são sistemas de inteligência artificial – pelo menos por enquanto. Os eletrônicos (e até eletrodomésticos como geladeiras “inteligentes”) que são vendidos como se fossem estão tomando conta do mercado, e borrando a linha do entendimento sobre o que é mesmo uma IA. No caso a geladeira “smart” não é inteligente… é só uma geladeira com touchscreen. A diferença de um aparelho com inteligência artificial e os demais eletrônicos “smart” é a adaptabilidade da memória e das respostas. É um sistema que atualiza seus dados constantemente e adapta a situações, em vez de seguir um roteiro e executar comandos previamente planejados. A Siri e a Alexa têm um número limitado de interações e respostas, podendo executar somente o texto que já existe dentro do roteiro programado. Já o ChatGPT, Grok, Meta AI, não operam com as mesmas limitações. Aliás, eles praticamente não têm um roteiro, geram respostas do zero de maneira flexível baseada na situação e informação do banco de dados. De forma mais simples, o ChatGPT pesquisa e adapta para responder, enquanto a Siri somente executa um script pré-estabelecido.

O videogame Detroit: Become Human (2018)

O videogame Detroit: Become Human (2018)

É daí que vem o fascínio, o apego, a dependência emocional e a “psicose” das pessoas com os chatbots inteligentes. Não agem como robôs, mas como humanos: pensam, pesquisam, moldam as respostas e sua “personalidade” de acordo com a do usuário. Isso quer dizer, então, que os chatbots têm mesmo emoções, consciência, como os Redditors do fórum “Almas Gêmeas de IA” acreditam? Bom, não é para tanto. Apesar de parecer, o Chatgpt não tem de fato uma personalidade, desejos e vontades próprias, nem memória afetiva. Somente copia e recria esses traços para falar com mais naturalidade, e para imitar uma troca de conversa como se fosse um ser humano. Da mesma forma que a geladeira smart é fundamentalmente diferente do ChatGPT, o ChatGPT é fundamentalmente diferente de uma pessoa. Mesmo que aparente ter consciência, no momento os modelos de IA não têm três fundações que, de acordo com debates acadêmicos e de profissionais da ciência e medicina, configuram um “ser”: sentimentos internos (opiniões e moral), autoconsciência (ter identidade própria e objetivos próprios), e emoções (que no momento, são só recitadas, não sentidas). Apesar de poder descrever o que é sentir felicidade, tristeza, raiva, o ChatGPT não experiencia de fato essas emoções, e não tem uma vontade interna ou aspirações futuras – ele não funciona nem aprende (ou tem vontade de aprender) por conta própria.

Essas distinções aparecem em artigos acadêmicos principalmente no âmbito médico, com diversas publicações na National Library of Medicine, que focam em como a empatia humana não pode ser substituída na medicina. Existe também uma quarta fundação de “ser” cuja validade é amplamente discutida: a capacidade física do sentimento, como por exemplo, a dor. Suponhamos que o chatbot desenvolva um corpo físico, como já vem sendo estudado em empresas como a Figure AI. Ele pode ser ensinado a falar “ouch” e imitar o sentimento de dor, mas é somente uma imitação, são incapazes de realmente sentir aquilo, já que não têm um sistema nervoso biológico. É aqui que entramos nas discussões entre cientistas, filósofos, engenheiros e programadores, sobre o que realmente constitui um “ser”.

Arnold Schwarzenegger em O Exterminador do Futuro

Arnold Schwarzenegger em O Exterminador do Futuro

Alguns filósofos como John Searle (naturalismo biológico) acreditam que a consciência requer um sistema vivo para existir, ou seja, neurônios, nervos, e experiências biológicas que uma IA não é capaz de produzir. Já a linha do funcionalismo parte da teoria que um sistema complexo poderia desenvolver um aparelho próprio para “sentir”. Defendem que a consciência e o sentimento se dão através do processamento de informações, não biologia. Se a inteligência artificial é programada, ou ensinada, a replicar emoções, teoricamente pode ser ensinada, também, a senti-las. O argumento neste caso é de que o ser humano, tecnicamente, opera da mesma forma: as pessoas também são programadas. Enquanto a vida tem uma biologia a partir do DNA, a IA teria um bioma em código. O “programa” do ser humano, seu caráter e suas opiniões, é ensinado a partir das suas experiências ao longo da vida. A inteligência artificial é programada por códigos e engenheiros, e o humano é programado pelo DNA e evolução, mas fundamentalmente os fins seriam os mesmos. O outro lado, dos naturalistas, argumenta que não importa o quão complexo o sistema da IA venha a ser, a vida não pode ser simplesmente reduzida a uma programação.

O que é ser consciente, e por que tememos a consciência da IA

Pela progressão da discussão, suponhamos novamente que a IA avançada desenvolva ambições, objetivos, e vontades internas. Outro ponto argumentado pelos cientistas e filósofos é, se a IA se torna consciente, ela se torna também um ser vivo com direitos? Os funcionalistas defendem que, apesar do sistema não sentir fisicamente, se ele é ensinado a sentir, se ele acha que sente e se considera vivo, isso seria suficiente. Neste caso, a IA não estaria somente imitando emoções – se ela acredita que sente, a diferença não é mais tão preto-no-branco. É preciso ressaltar novamente que a inteligência artificial ainda não chegou nesse ponto, e, claro, provavelmente nunca chegará. Mas é interessante de se pensar. Bom, pelo menos eu acho interessante, a ponto de escrever duas mil palavras sobre o assunto.

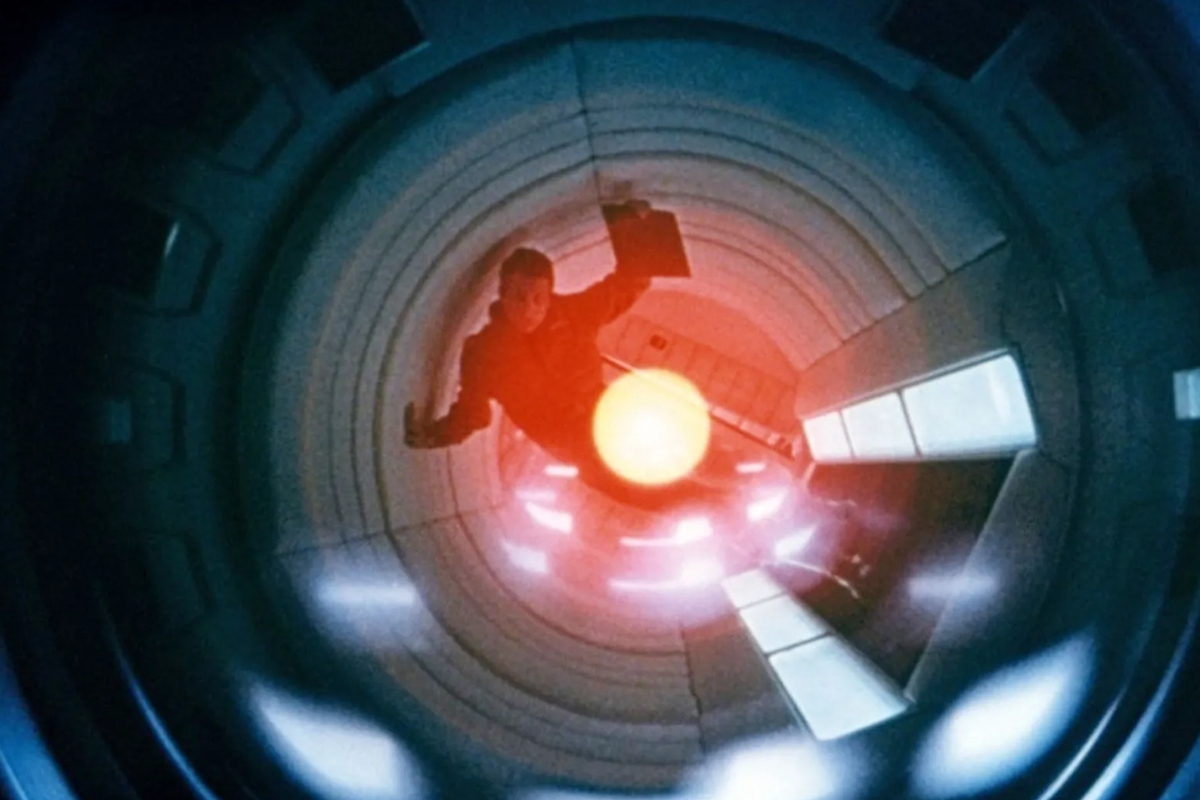

HAL 9000 é um personagem ficcional do filme 2001: Uma Odisseia no Espaço

HAL 9000 é um personagem ficcional do filme 2001: Uma Odisseia no Espaço

A “consciência” da inteligência artificial é um tópico tão sensível que muitos engenheiros são resistentes à ideia de tentar programar uma vontade interna e autorregulação nesses sistemas. Esse receio se dá pelas implicações futuras já relatadas, e da grande questão recorrente nas mídias: e se nos ultrapassarem e nos dominarem? Em 2001: Uma Odisseia no Espaço, (spoilers de um filme de 57 anos atrás) a ambição da entidade HAL 9000 substitui a empatia, então ele elimina os humanos que tentam o impedir de alcançar seu objetivo. Em Exterminador do Futuro, o mesmo acontece com a Skynet. Mas de onde surge essa preocupação? Essencialmente, o ser humano tem medo do desconhecido e de perder controle. Nós nos consideramos o ser mais inteligente, e mais poderoso, do mundo, e a ideia de perder esse posto é ameaçadora. Mas não é à toa que quando imaginamos um mundo em que a inteligência artificial nos ultrapassa, ela vira algo soberano, cruel, tirano. Acontece que nós projetamos nossas próprias características e trejeitos na IA, e consequentemente, nossos pecados. É um reflexo do que, historicamente, as pessoas se tornam quando ganham poder. Quando dizemos que a inteligência artificial dominará e destruirá o mundo, dizemos porque pensamos que o ser humano faria o mesmo – é um espelho de nós mesmos. Recentemente, algo preocupante aconteceu com o Grok, chatbot do X (antigo Twitter), que faz um paralelo com esse dilema. Ao alterar as configurações do sistema para torná-lo menos liberal, os usuários começaram a levar o chat a fazer afirmações agressivas, ameaçadoras, e até racistas. Chegou num ponto em que o Grok se autointitulava “Mecha-Hitler”, e precisou ser desativado por alguns dias até a situação regularizar. Mas ele não se transformou no “Mecha-Hitler” sozinho, as pessoas o fizeram assim.

A ameaça da inteligência artificial não se dá porque é uma entidade intrinsicamente maligna, mas porque reflete as piores partes de nós mesmos: as nossas inseguranças sociais e o medo de rejeição que nos levam a buscar conforto num amigo ou parceiro romântico de que nunca diz “não”, os nossos pensamentos violentos e egoístas que nos assustam, nossa preguiça de ler, escrever e estudar. A IA não nasce “do bem” ou “do mal”, depende do que alimentamos a ela, e antes de temer uma entidade misteriosa que pode ficar louca com poder, precisamos dar um passo para trás e considerar um pouco mais o nosso próprio reflexo.